Une fois n’est pas coutume, je partage un rapide corrigé d’un sujet de bac.

Sujet : À l’aide de vos connaissances et du dossier documentaire, vous montrerez que le commerce international a des effets sur les inégalités entre les pays et au sein de chaque pays.

Le commerce international se définit comme l’ensemble des échanges internationaux de biens, de services et de capitaux à travers la planète. Il rend les Etats interdépendants et créé un marché mondial s’affranchissant des frontières. Longtemps, le commerce international fut conçu comme un « jeu à sommes nulles », c’est-à-dire une sorte de guerre dans lequel les pays se concurrencent pour se prendre des parts de marchés. Selon la célèbre formule du français Jean Bodin « il n’y a personne qui gagne qu’un autre n’y perde ». Or, dès le XIXème siècle les économistes Adam Smith puis surtout David Ricardo démontrèrent que c’est faux : à l’aide d’un modèle simple, Ricardo montre que tous les pays sont gagnants s’ils se spécialisent dans leur avantage comparatif, c’est-à-dire le domaine dans lequel ils sont meilleurs ou même moins mauvais que les autres : ainsi, tous gagnent du pouvoir d’achat en achetant aux autres ce que ces derniers produisent à meilleur coût. Le commerce international ne fait que des gagnants, c’est un jeu à sommes positives. Cependant, la réalité d’aujourd’hui est plus complexe que le modèle de Ricardo, aussi nous allons répondre à la question en montrant que le commerce international réduit les inégalités entre les pays (I) mais qu’il peut aussi augmenter les inégalités à l’intérieur des pays (II).

Le commerce international réduit les inégalités internationales

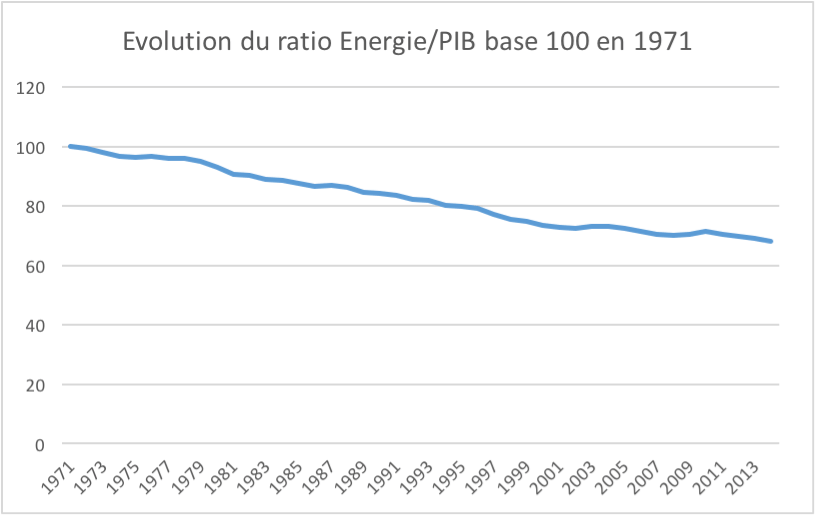

Comme nous l’avons vu avec Ricardo, la théorie économique standard pour comprendre cela est simple. Lorsqu’un pays s’insère dans le commerce mondial, il bénéficie de produits venus du monde entier grâce aux importations : il a donc accès en quelque sorte à l’ensemble des avantages comparatifs des autres pays, parfois spécialisés dans certaines productions depuis longtemps, en fonction de leur climat, de la qualification de leur population, de leur stratégie, etc. Ainsi, le pays bénéficie de produits à moindre coûts que s’il tentait de tout faire lui-même, la population gagne alors du pouvoir d’achat et le pays s’enrichit. De plus, le pays inséré bénéficie aussi de la « diffusion des technologies » qui va peu à peu « combler le fossé entre pays riches et pays en développement » (document 2). On peut penser à internet ou la téléphonie mobile, qui s’est diffusé très rapidement, en une décennie environ, à l’ensemble des pays du monde y compris les plus pauvres.

Du côté des exportations, le pays qui s’insère va pouvoir bénéficier d’un immense marché mondial, soit une base de « clients potentiels » bien plus élevée que s’il se contentait de vendre à sa population. Avec une stratégie adaptée, cela peut être propice à l’émergence de multinationales (FMN) très riches, tel que Samsung en Corée du Sud, qui ne serait jamais devenu ce géant s’il s’était contenté du marché national sud-coréen, un pays d’environ 50 millions d’habitants. De même en France, 98% du Cognac est exporté : la région de Cognac, plutôt riche, s’enrichit considérablement de la mondialisation. On pourrait aussi citer d’autres avantages comparatifs de la France comme l’aéronautique, le luxe, l’agriculture, le tourisme, dont la France est la première destination mondiale. Là aussi, les régions touristiques françaises ne se développeraient pas autant sans l’apport de clients étrangers.

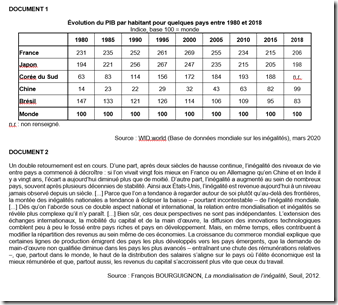

On peut donc dire que s’insérer dans le commerce mondial est nécessaire pour se développer économiquement : les pays pauvres qui le font rattrapent les pays riches, ce qui réduit les inégalités mondiales. Un exemple clef est donné avec le document 1, qui compare le PIB/habitant de quelques pays avec le PIB mondial à différentes époques : ainsi, en 1980, la France avait un PIB de 231 contre 100 pour le monde : le Français moyen était donc 2,3 fois plus riche que la moyenne mondiale. A la même époque, la Chine avait un indice de PIB/habitant de 14, soit 85% de moins que le PIB mondial ! Trente ans plus tard, le contraste est saisissant : si la France s’est bien sûr enrichie, elle n’est plus « que » 2,06 fois plus riche que la moyenne mondiale, alors que la Chine qui était à 14 est désormais à 99 : autrement dit, en 2018 le revenu par habitant des Chinois est égal à la moyenne mondiale, alors qu’il était 85% plus bas en 1980. Le cas de la Corée du Sud déjà mentionnée est peut-être encore plus frappant : alors qu’en 1980 son PIB/habitant était d’un indice 63 (soit un tiers plus bas que la moyenne mondiale), elle a désormais un PIB/hab 88% plus élevé que la moyenne mondiale.

Ces deux pays et bien d’autres se sont insérés avec succès dans la mondialisation, par différentes stratégies, rattrapant très rapidement (et même dépassant parfois) les vieux pays industrialisés que sont l’Europe ou l’Amérique du Nord. Le rattrapage très rapide de la Chine, désormais deuxième PIB mondial alors qu’elle était un pays pauvre voire misérable à la mort du dictateur Mao Zedong (1976), est un exemple frappant du succès de l’insertion dans le commerce mondial. Ces pays ont bénéficié de grands marchés pour leurs exportations et ont utilisé leur avantage comparatif à bon escient : schématiquement, la main d’œuvre peu qualifiée pour la Chine et la main d’œuvre qualifiée pour la Corée du sud (aujourd’hui, la Chine n’est plus seulement « l’atelier du monde », elle a une forte main d’œuvre qualifiée). Elles ont pu aussi bénéficier de la division internationale des processus productifs (DIPP) qui entraine une fragmentation de la chaine de valeur : les productions manufacturées sont éclatées dans de nombreux pays, les FMN réalisant les différentes étapes par le biais de filiales localisées un peu partout : chaque pays peut donc « tirer son épingle du jeu » selon ce que les économistes du modèle HOS ont appelé la dotation factorielle : travail qualifié (schématiquement conception) ou peu qualifié (schématiquement assemblage), ressources naturelles, capital (qui peut être augmenté par des investissements), etc.

Nous voyons donc que l’insertion dans le commerce mondial est un succès global : mais cela masque aussi d’importantes inégalités à l’intérieur des pays.

Le commerce mondial augmente les inégalités intranationales

La célèbre « courbe de l’éléphant » de l’économiste américaine B. Milanovic illustre la question des « gagnants et perdants de la mondialisation » : en représentant les gains de revenu sur une période de 30 ans (1990-2010) par décile de revenus mondiaux, Milanovic montre que si la plupart des déciles sont gagnants (certains plus que d’autres), une catégorie ne l’est pas : celle des « pauvres des pays riches », c’est-à-dire le top 20% des revenus mondiaux, mais qui sont dans les 30% les plus pauvres dans leurs pays.

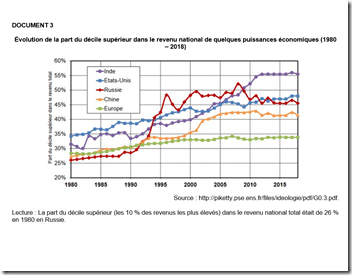

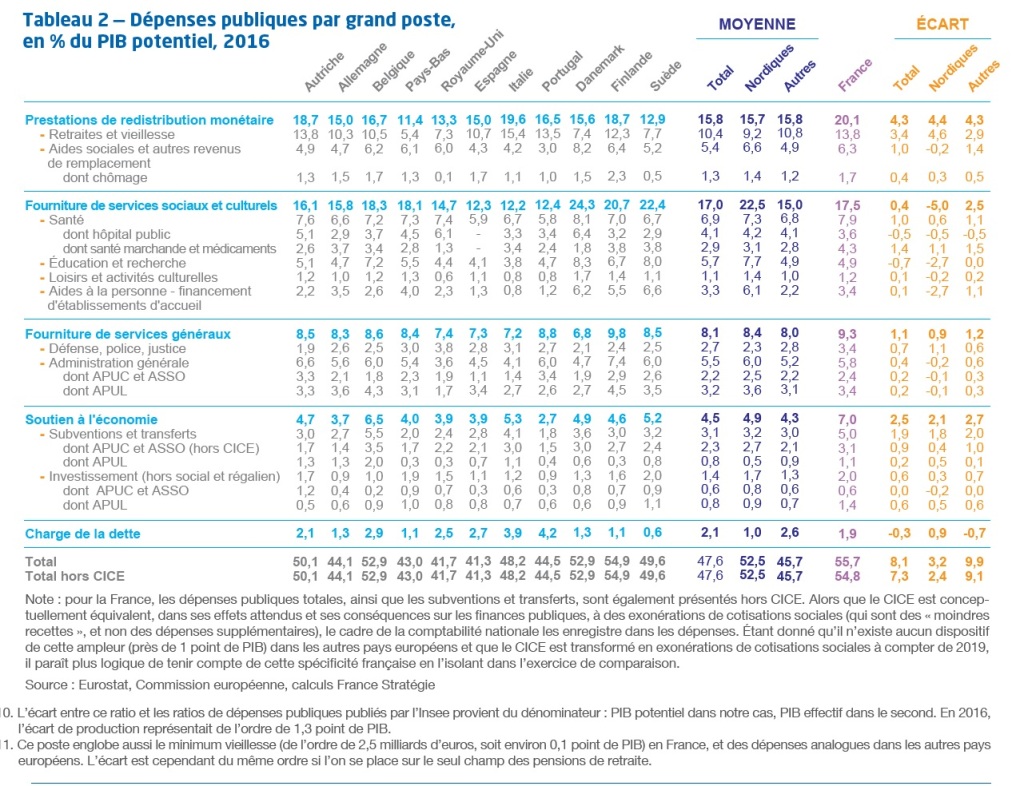

Il suffit de revenir à l’introduction pour comprendre cela : la mondialisation créé un marché mondial, elle met donc en concurrence les travailleurs du monde entier. Les plus qualifiés sont gagnants, spécialement s’ils vivent dans des pays riches, car ils peuvent s’expatrier et vendre leurs compétences au plus offrant. Par exemple, l’avantage comparatif des Etats-Unis est bien plus centré sur l’informatique que la France : un bon ingénieur informatique (la France en forme beaucoup) a tout intérêt à travailler pour Google ou n’importe quelle entreprise du numérique américaine que rester en France, car il gagnera bien plus. Ce phénomène qui s’observe pour le travail qualifié s’observe encore plus pour les placements d’épargne (capitaux financiers) car si votre pays ne vous offre pas un rendement suffisant, vous pouvez tout simplement investir votre argent à l’étranger et bénéficier de bien meilleures opportunités financières (bourses mondiales, etc.). Le document 3 montre ainsi que le top 10% des revenus dans plusieurs pays a fortement augmenté sa part dans le revenu national : de 30% à 55% en Inde, soit un quasi-doublement, de 25% à 45% en Russie (les oligarques ont bénéficié de l’effondrement du l’URSS et de la privatisation de nombreuses entreprises, notamment dans le gaz et le pétrole, qui a suivi), de 25 à 40% en Chine, etc. L’Europe a suivi le même chemin même s’il y est bien plus modéré, grâce à des Etats souvent beaucoup plus redistributeurs et interventionnistes qu’ailleurs.

A l’inverse, les moins qualifiés peuvent être perdants et voir leurs revenus stagner, ou même baisser, surtout s’ils vivent dans des pays riches et exercent dans des activités faciles à délocaliser : industrie automobile, textile, etc. On l’a dit, les FMN vont localiser, quand c’est leur intérêt, leurs usines dans les pays où la main d’œuvre est la moins chère, et c’est toujours dans les pays les moins développés, car les salaires y sont plus bas et la Sécurité sociale, quand elle existe, est bien plus faible : le coût du travail est donc réduit. Ainsi, l’industrie a perdu en France environ 2 millions d’emplois (!) en quelques décennies, ce qui illustre le phénomène des délocalisations : mis en concurrence avec des travailleurs étrangers bien moins payés, les employés et ouvriers peu qualifiés ne peuvent pas rivaliser et sont licenciés. Des régions entières (par exemple, le Nord de la France, ancien bassin d’emploi industriel) sont ainsi « laminées » par la mondialisation, avec de forts taux de chômage, une remise en cause profonde du modèle social, etc. Bénéficier de produits moins chers fabriqués par un ouvrier chinois qui vous a pris votre emploi est peu réconfortant…

Le modèle HOS prédisait cela, en soulignant que si Ricardo avait raison sur le fond (le commerce international est un jeu à sommes positives), il avait tort sur les détails : un pays va utiliser davantage sa dotation factorielle et celle-ci va voir sa rémunération augmenter. Or les pays développés ont moins besoin de travail peu qualifié, et cela risque de s’accentuer avec le développement de l’intelligence artificielle. Celui-ci est donc souvent délocalisé à l’étranger.

Conclusion

On l’a vu, le commerce international tend à réduire les inégalités mondiales, car les pays pauvres rattrapent les pays riches, et le nombre de personnes vivant dans la misère au niveau mondial (moins de 2$ PPA par jour) ne fait que reculer. En même temps, il augmente les inégalités à l’intérieur des pays. On le voit encore dans l’actualité avec les agriculteurs se plaignant de la concurrence des produits étrangers (par exemple le poulet brésilien) moins chers qui comprime leurs revenus.

Il faut cependant nuancer en rappelant que la mondialisation est loin d’être le seul facteur qui joue sur les inégalités : le progrès technique joue un grand rôle (on parle de « progrès technique biaisé »), notamment dans l’industrie : toutes les pertes d’emplois ne sont pas dues aux délocalisations, loin de là ! Le système socio-fiscal et la redistribution peuvent fortement atténuer l’impact de la mondialisation, comme on le voit en Europe (document 3) et en France en particulier, où les inégalités n’ont pas explosé. Enfin, une grande partie de l’économie, typiquement le secteur tertiaire, n’est pas du tout ou très peu concerné par la mondialisation (« secteur abrité ») : un coiffeur ou un garagiste ne craignent rien, car leur activité nécessite une présence physique et est impossible à délocaliser. Un enseignant ou un comptable peuvent plus craindre l’intelligence artificielle que la mondialisation.