Je termine de lire la (très longue) note technique de Guillaume Hazenno, l’un des meilleurs spécialistes des finances publiques en France. Je me permets d’en faire ici un commentaire détaillé.

1-Les faits sont connus : la France cumule une dette importante (cinquième de l’OCDE), des marges de manœuvres budgétaires faibles (premier taux de prélèvements obligatoires), des dépenses publiques structurellement élevées (encore la première place), et des déficits qui crèvent le plafond depuis quelques années.

2- Pourquoi réduire les déficits ? Les économistes savent et répètent que l’Etat n’étant pas mortel, le stock de dette n’a pas une grande importance tant qu’il peut faire « rouler sa dette », c’est-à-dire emprunter pour payer ses emprunts. Il faut néanmoins payer les intérêts rubis sur l’ongle pour que les « marchés financiers » —entité abstraite en réalité composé de retraités, d’entreprises, de banques, de ménages du monde entier, France comprise— continuent de prêter, c’est-à-dire de placer leur épargne dans des obligations de l’Etat français, essentiellement des OAT à dix ans.

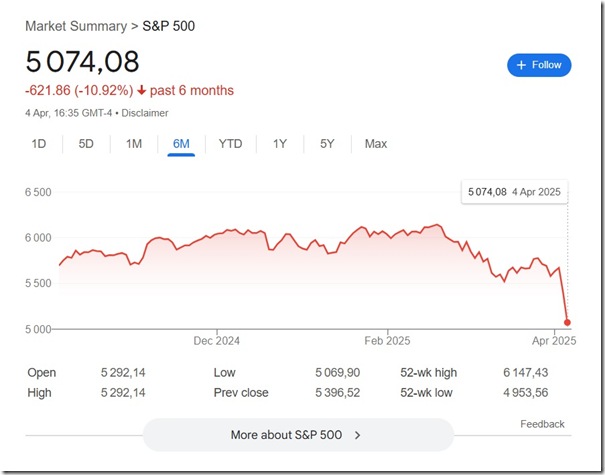

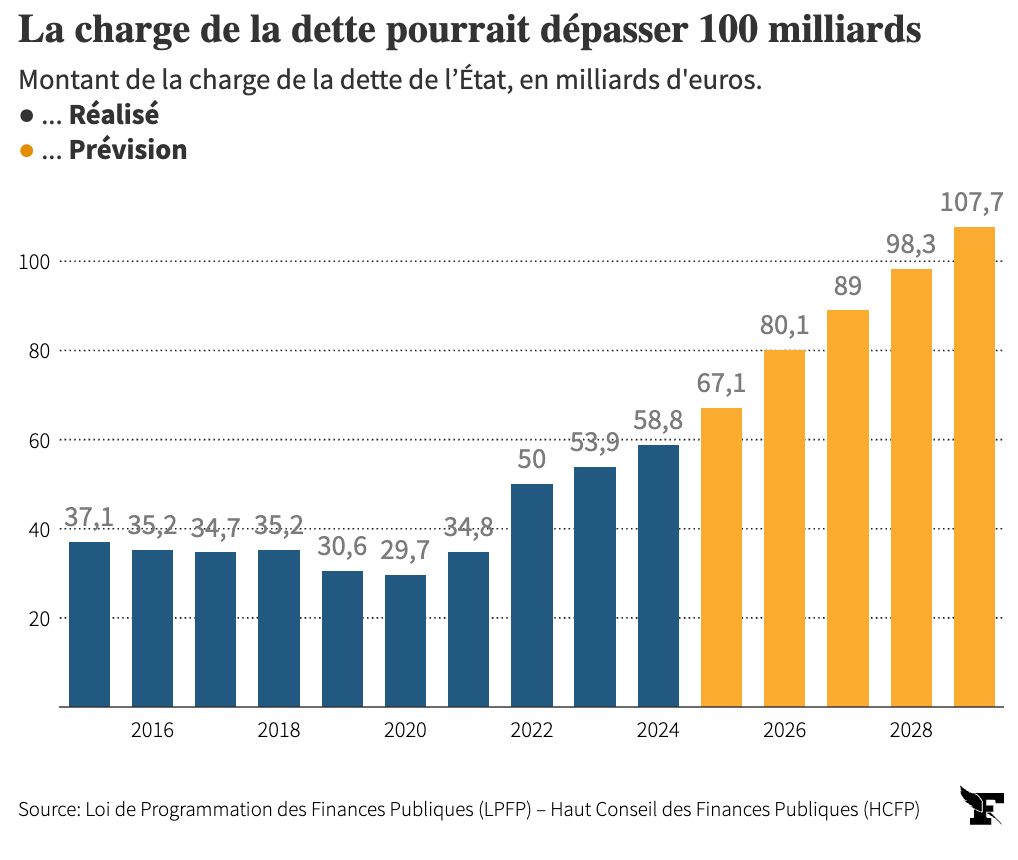

3-Or le coût de notre dette publique va bientôt s’envoler. D’une part, parce que les OAT placés par l’agence de l’Etat France Trésor à des taux faibles (~1%) arrivent à échéance et vont être progressivement remplacés par des OAT aux taux actuels, autour de 3% fourchette basse. La charge de la dette dépassera bientôt les dépenses d’éducation pour devenir le premier poste budgétaire de l’Etat : Hannezo la chiffre à 75 milliards/an dès 2027 ! Le régime d’inflation faible entraîné pendant des années (2009-2022) par les politiques de « quantitative easing » a aussi pris fin, ce qui augmente nettement le coût réel des dettes publiques.

4-Les marchés sanctionnent d’ailleurs déjà la France, qui emprunte à des taux égaux à ceux de l’Italie et plus élevés que ceux de la Grèce, du Portugal, de l’Espagne… pays que la planète finance qualifiait naguère de pays du « club Med » ! Quant à l’écart (spread) avec le pays de référence, l’Allemagne, il a doublé depuis que Macron a pris le pouvoir.

5-Entre le catastrophisme et le rassurisme, il y a une position équilibrée. La France est un grand pays développé membre de l’euro, avec une administration fiscale centralisée, informatisée, très capable de collecter l’impôt, et un taux d’activité informel beaucoup plus bas que les pays du sud de l’Europe : il faudrait que la situation soit critique pour que tout s’emballe. N’allons pas pour autant imaginer que la BCE nous protègera de tout et surtout sans contreparties. Cela reviendrait à penser que les Européens sont des vaches à lait qui vont gentiment payer pour les dépenses sociales des Français sans rien exiger en échange. Même largement aidés, l’Italie, l’Espagne et le Portugal, sans parler de la Grèce, ont dû faire de lourds sacrifices pour surmonter l’austérité des années 2010. Hannezo rappelle que dans le cas de la Grèce, 30% du pouvoir d’achat fût sacrifié en 5 ans, ce qui effaça la totalité des progrès accomplis en une génération. Il faut bien l’orgueil français pour croire que cela ne peut pas nous arriver, surtout si 2027 voit Jordan Bardella prendre le pouvoir : eurosceptique d’une main et quémandant l’aide des Européens de l’autre, autant dire qu’il sera fraichement reçu à Bruxelles et à Francfort.

La France n’est ni l’Argentine ni la Grèce, mais elle n’est pas non plus l’Allemagne —laquelle a fait également de lourds sacrifices économiques pour payer sa réunification— encore moins les Etats-Unis. Personne ne peut dire avec certitude si et quand la situation deviendra incontrôlable. Mais personne ne peut prendre le risque qu’elle le devienne. C’est d’ailleurs la raison pour laquelle malgré des comptes publics objectivement catastrophiques, la situation sur les marchés semble encore « raisonnable » : 3.5% est un taux qui ferait pâlir d’envie de nombreux pays du Sud global. C’est qu’en dehors de quelques fonds spéculatifs, personne n’a intérêt à voir la septième économie mondiale faire défaut sur sa dette, surtout pas ses prêteurs. Comme dit l’adage : quand vous devez 100€ à votre banquier, c’est votre problème, mais quand vous lui devez 100 milliards, c’est son problème.

6- Donc, la France va devoir réduire son déficit public assez vite et trouver au minimum 100 milliards d’économie en quelques années. Ce chiffre ne sort pas du chapeau : il s’agit d’après Hannezo de l’estimation minimale qui, en tenant compte de la progressions des taux d’intérêts, de l’augmentation des besoins (population qui vieillit, dépenses militaires, transition écologique,…), permettrait non pas de réduire la dette publique, ni même de la stabiliser en valeur nominale, mais simplement d’éviter qu’elle ne progresse tendanciellement plus que la croissance, entrainant dans son sillage une envolée en spirale de la charge d’intérêts —le fameux effet « boule de neige ». Et ce, à supposer qu’aucune crise majeure de type pandémie ou guerre de haute intensité ne vienne encore mettre à l’épreuve les comptes de l’Etat. D’après Hannezo, sous des hypothèses moyennes il faudrait trouver presque 150 milliards en six ans. Un effort colossal, presque impossible.

7- Comprendre les causes est plus important que chercher des responsables. Du reste, le dernier budget excédentaire français remonte à 1974 : autant dire qu’on peut remonter loin. On n’accumule pas 3300 milliards de dette le temps d’un quinquennat. Surtout, comme cela avait déjà été montré pour le cas américain —le déficit américain ayant triplé sous la présidence de Ronald Reagan— il n’y a guère de lien entre couleur politique du gouvernement et déficits publics. Si la gauche est traditionnellement associée aux dépenses sociales incontrôlées, elle a aussi tendance à augmenter les impôts, ce qui compense l’impact des dépenses sur les déficits. A l’inverse, la droite qui fait vertu de rigueur peut se montrer très dépensière lorsqu’il s’agit de dépenses de sécurité et de défense, et aggrave souvent les déficits par des baisses d’impôts générales.

Quant au dernier arrivé, il porte bien entendu la plus lourde responsabilité. S’il n’a pas créé la dette française, ni les tendances de fond qui l’entretiennent, Hannezo démontre chiffres à l’appui qu’il a fait déraper les comptes publics dans des proportions jamais vues sous la Vème République, même quand on retire l’effet covid. Pour l’essentiel, cela tient à un grand nombre de réductions d’impôts non financées, à commencer par la suppression de la taxe d’habitation qui coûte à elle seule 20 milliards par an aux finances publiques (et que personne ne demandait !), à quoi s’ajoutent de nombreux allègements fiscaux pour les entreprises qui se chiffrent en dizaines de milliards. Les dépenses n’ont pas été en reste avec une hausse très importante des dépenses militaires dans le contexte que l’on sait, le « Ségur de la santé » pour environ 11 milliards, 25 milliards pour les aides à l’apprentissage, et ainsi de suite. À la fin, la progression de la dette sous Macron se situe dans un ordre de grandeur de 1000 milliards d’euros, c’est-à-dire, fin 2025, à dix-huit mois de la remise des clefs par le locataire de l’Elysée, d’un montant (légèrement) supérieur à celui des quinquennats cumulés de Sarkozy et Hollande.

L’interprétation politique de Hannezo est qu’après les Gilets Jaunes et une politique de l’offre tous azimuts, Macron n’a pas eu le courage d’installer les hausses d’impôts compensatoires qui étaient prévues dans son programme, notamment d’augmenter la CSG, car cela touchait au seul électorat qui lui restait et qui l’a réélu en 2022 : les retraités. Le covid et la guerre en Ukraine ont accentué un « quoi qu’il en coûte » qui, contrairement aux autres pays développés, s’est prolongé après la pandémie.

N’ajoutons rien à tout ce qui a été dit sur le désastre politico-économique de la dissolution. Bref, le « Mozart de la finance » restera comme le pire gestionnaire des comptes publics de la Vème République. Selon Hannezo, le creusement du déficit des deux quinquennats représente en % du PIB plusieurs fois celui de la fameuse relance de Mitterrand de 1981 !

8-Là où ça devient franchement déprimant, c’est que les alternatives à Macron sont fort médiocres. A droite, deux idées dominent : « lutter contre l’assistanat » et « réduire le train de vie de l’Etat ». A supposer qu’on soit à l’aise avec l’idée de s’attaquer aux plus fragiles, par exemple en taxant les malades chroniques, en sabrant encore dans un régime d’indemnisation chômage déjà plusieurs fois raboté, en s’attaquant aux bénéficiaires des minimas sociaux qui, une fois au pain sec et à l’eau, retrouveraient miraculeusement un travail rémunérateur qu’on pourra taxer, en réduisant la politique familiale ; à supposer qu’on choisisse d’ignorer tous les effets de bord catastrophiques qu’auraient de telles politiques —explosion des inégalités, effondrement de la fluidité sur le marché du travail, freinage de la natalité— il y a peu d’argent à récupérer. Au mieux, quelques pourcents de l’effort nécessaire.

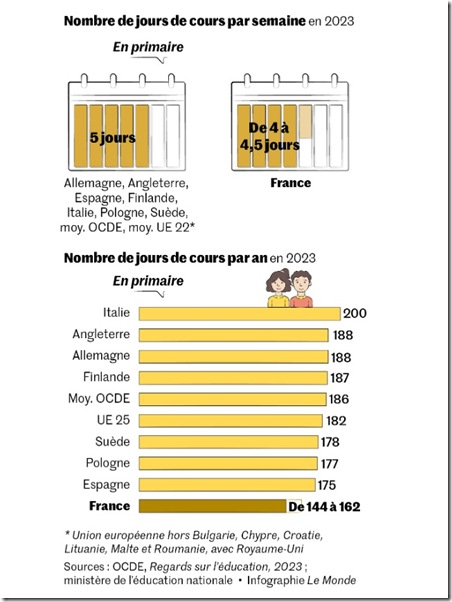

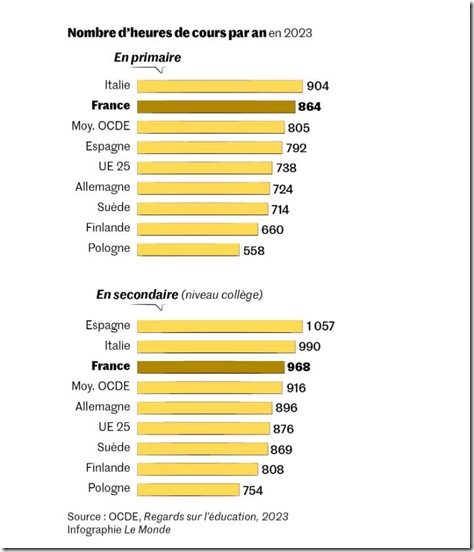

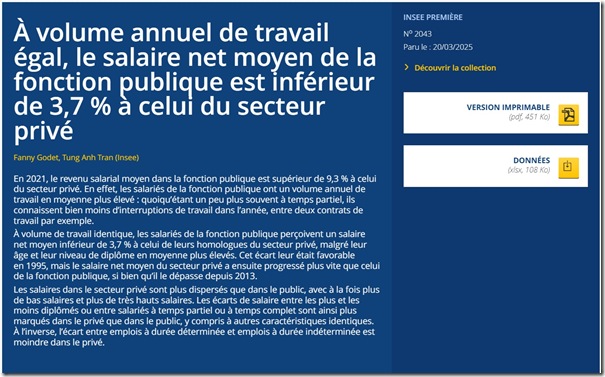

L’autre idée phare de la droite (« réduire le train de vie de l’Etat ») permet des économies encore plus dérisoires. Si par « train de vie » on parle de celui des politiciens, alors la mesure est de l’ordre du symbole : quelques dizaines de millions d’euros par an en mettant tout le monde au SMIC, à peine quelques jours de paiement des retraites. Si par « train de vie de l’Etat » on pense à des réductions du nombre de fonctionnaires, totem habituel de LR, les économies sont à peine plus significatives : moins de 800 millions d’euros par an durant le quinquennat Sarkozy pour la mesure « non remplacement d’un fonctionnaire sur deux ». Les raisons de cette absence d’effet majeur sont connues mais ce serait un peu long de développer ici. De plus ce genre de disposition générale dégrade généralement la qualité des services publics car l’Etat est incapable de cibler les « bons » fonctionnaires des « mauvais ».

Rien de ce qui précède ne signifie que des gains d’efficacité ne sont pas à faire dans la gestion des deniers publics : c’est l’évidence ! Mais cela dit prosaïquement que les gains à en attendre sont loin des ordres de grandeur évoqués au point 6, pour une raison simple : l’écart de dépenses publiques de la France par rapport à ses voisins provient très majoritairement de la redistribution monétaire, et non des services publics.

Quant à la gauche, sa proposition de taxer les riches (surtout les milliardaires) est bien plus consensuelle dans la société française. Mais, même en étant radical, Hannezo montre que, dans les hypothèses les plus favorables —et donc les moins probables— la taxation des riches ne permettra de faire qu’environ un tiers de l’effort.

9- L’Etat devra donc reprendre du pouvoir d’achat aux Français ordinaires, car c’est bien de cela qu’il s’agit quand on parle de réduction des déficits. Que cela passe par une baisse des dépenses ou une hausse des impôts ne change que marginalement la répartition de l’effort mais pas le fond du problème : dans les deux cas, l’Etat reprend de l’argent.

Bien entendu, le rythme auquel le faire est un débat politico-économique, mais il faut néanmoins le faire. Or, personne n’en a envie parce que personne n’en a intérêt. Hannezo rappelle à juste titre qu’il est difficile de trouver un Français qui ne vit pas d’une manière ou d’une autre de la dépense publique. Cela va bien au-delà des fonctionnaires et des bénéficiaires directs de notre immense système de redistribution qui socialise chaque année 55% du PIB : « retraités, chômeurs, médecins, infirmiers, laboratoires médicaux, taxis transportant des malades, qui sont payés par le système de protection sociale ; bénéficiaires du logement social ou des aides aux logements, et leurs propriétaires, car sans ces aides ils n’auraient pas pu autant augmenter les loyers ; agriculteurs dont une part très significative du revenu vient des aides européennes et nationales ; et aussi avocats travaillant pour l’aide juridictionnelle, ou journalistes bénéficiant des aides à la presse, ou associations financées largement sur fonds publics ; et aussi, pour une très grande part de leurs revenus, souvent la majorité, les sociétés de bâtiment et de travaux publics, ou les sociétés privées – audit, informatique, conseil, commissariat aux comptes, facility management – pour la part de leur chiffre d’affaires réalisé avec des entités publiques ou des bénéficiaires des transferts. Tout cela fait beaucoup de monde ».

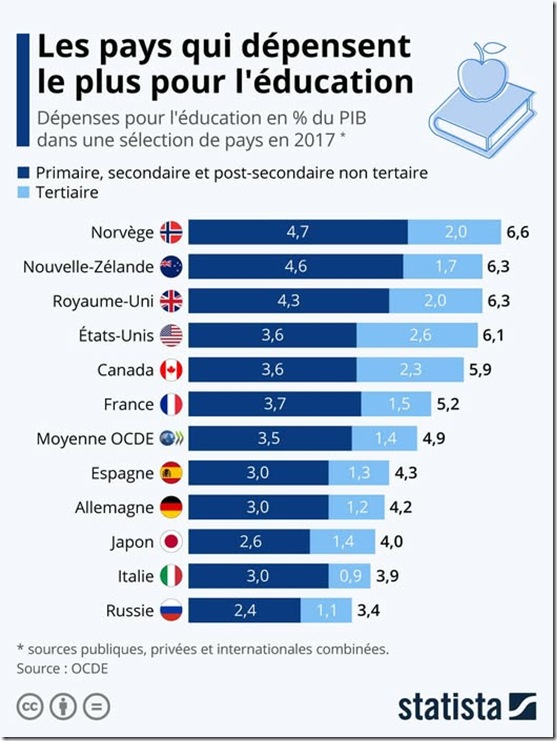

Il serait tentant de reprendre ici la formule du polémiste libéral Frédéric Bastiat, en 1848 : « L’Etat, cette grande fiction par laquelle tout le monde tente de vivre aux dépens de tout le monde ». Mais ne jetons pas le bébé avec l’eau du bain : la redistribution est évidemment nécessaire et obtient des résultats. La France a toujours maintenu des inégalités stables et relativement basses, les patients Français ont un reste à charge parmi les plus bas du monde, tout comme notre taux de pauvreté, l’un des plus faibles de l’OCDE. Personne ne souhaite sérieusement imiter les Etats-Unis, où le système de santé est catastrophique et où les inégalités explosent depuis une trentaine d’années. On pourrait en revanche s’inspirer des pays qui font tout aussi bien —voire mieux— avec moins. L’Etat danois dépense quasiment 10 points de PIB en moins que la France, tout en ayant un taux de pauvreté nettement inférieur : 6,3% contre 8,5%. On peut en dire autant de la Norvège, de la Suède ou même de nos voisins belges. La France obtient donc des résultats, mais en regard des moyens investis, elle ne brille pas par son efficience.

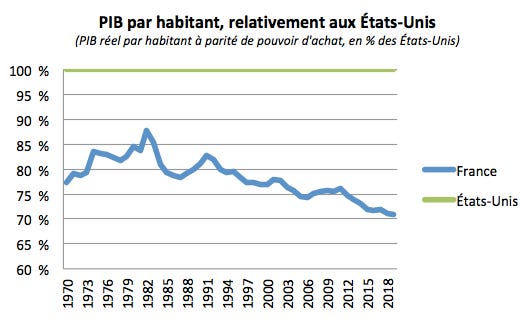

Même en admettant que le montant de la dette n’est pas un problème, force est de constater que les masses d’argent empruntées depuis des décennies n’ont pas empêché notre PIB par habitant de reculer par rapport aux Néerlandais, aux Allemands, aux Danois ou aux Britanniques. À la 7ème place européenne des PIB/habitant dans les années 2000, nous sommes désormais 14èmes. Si on le mesure autrement, par exemple en calculant la part de la France dans l’économie de la zone euro, on obtient le même résultat : nous reculons.

10- On aura compris que 2027 s’annonce crucial. Le prochain Président ou la prochaine Présidente devra non seulement engager l’effort en endossant dès le départ une forte impopularité, ce qui suppose d’avoir une majorité claire, mais en plus devra-t-il doser et répartir l’effort : en premier les milliardaires, bien sûr, sans quoi rien ne se fera ; les grandes entreprises, qui ont énormément bénéficié des années Macron et dont les surprofits sont anormalement hauts ; mais aussi les consommateurs : Hannezo estime que le taux de TVA français est anormalement bas par rapport à son niveau de dépenses publiques. Tous les pays européens sauf l’Allemagne ont des taux standards plus élevés, jusqu’à 25% pour le Danemark qui a des dépenses publiques comparables à la France.

Enfin et surtout faudra-t-il s’attaquer au poids extraordinairement élevé de nos dépenses de retraite, tabou politique exceptionnel en France. Citons encore l’expert :

« les retraites sont le premier poste de dépenses publiques ; la France s’endette de 3 à 4 points de PIB de plus que ses voisins pour cela – c’est l’écart de déficit – dont 2 à 3 viennent de ce qu’elle a choisi de verser des retraites assurant à leurs bénéficiaires un niveau de vie en moyenne égal ou supérieur (selon les conventions de calcul) à celui des actifs, et en moyenne supérieur à leurs besoins en dépenses, la meilleure preuve étant qu’ils en épargnent en moyenne une très forte part, plus que les actifs. Cette épargne, les retraités la placent dans des placements sûrs, notamment les emprunts d’État à travers l’assurance-vie. Comme ils continuent d’épargner même après 75 ans, cette sur-épargne moyenne, qui bien sûr est localisée sur la fraction la plus aisée de la population, vient chaque année arrondir leur héritage. La redistribution qui s’opère là est claire : à travers le déficit budgétaire tous les actifs de la génération suivante s’endettent pour un profit que recevront… les héritiers des classes bourgeoises. C’est une contre-redistribution organisée sur le long terme »

A nouveau, le prochain chef (ou cheffe) de l’Etat devra trouver un moyen de répartir l’effort, l’extraordinaire impopularité des dernières réformes tenant largement au fait de le porter exclusivement sur les actifs et via une seule mesure —la hausse de l’âge légal— alors qu’il en existe d’autres. D’autres pays l’ont fait et la France elle-même en a vu d’autres : l’auteur explore notamment le cas du plan de redressement de 1958 et du « tournant de la rigueur » de 1983. Mais plus on attend, plus sévère sera la potion.